Les représentations

La physique semble soumise aux symétries (jamais les solutions d’un problème ne s’affranchissent des symétries qui contraignent le système). Essence des symétries, les groupes sont l’objet idéal pour décoder ce lien indéfectible.

Mais on ne manipule pas “la physique”, seulement des objets mathématiques sensés modéliser la réalité sous-jacente. Ces objets sont toujours les solutions d’équations différentielles ou intégrales et vivent donc dans des espaces vectoriels. Le mariage entre physique et espaces vectoriels fut même entièrement consommé à l’avènement de la physique quantique puisqu’ils constituent le cadre fondamental de la théorie.

Cela serait donc sympa que l’on réussisse à balancer nos symétries dans ces espaces vectoriels… Les représentations sont là pour ça.

Une représentation, c’est la description d’un groupe dans un espace vectoriel.

Mais maintenant qu’on a un peu de vocabulaire, disons qu’une représentation d’un groupe est le résultat d’un homomorphisme de ce groupe vers le groupe des opérateurs linéaires sur les espaces vectoriels (espace des états physiques pour ce qui nous intéresse). Ces opérateurs sont incarnés par des matrices dès qu’on a une base.

on peut vérifier que les matrices carrées d’un ordre donné forment bien des groupes vis-à-vis de la loi de multiplication entre matrices si néanmoins elles ont le bon goût d’être inversibles :

- à toute matrice inversible d’ordre n correspond bien sûr une matrice inverse, elle-même inversible et d’ordre $n$,

- matrice inversible d’ordre $n$ $\times$ matrice inversible d’ordre $n$ $=$ matrice inversible d’ordre $n$,

- la multiplication de matrices est bien associative,

- la matrice identité d’ordre $n$ sert d’élément neutre.

Définition “technique” d’une représentation :

$U\left(g_1\right) U\left(g_1\right)=U\left(g_1 \cdot g_2\right)$

Et sur une base orthonormée de l’espace vectoriel (de dimension finie), l’opérateur $U$ est associé à une matrice $D$ :

$U(g)\left|e_i\right\rangle=\left|e_j\right\rangle D(g)^j_{\,i}$

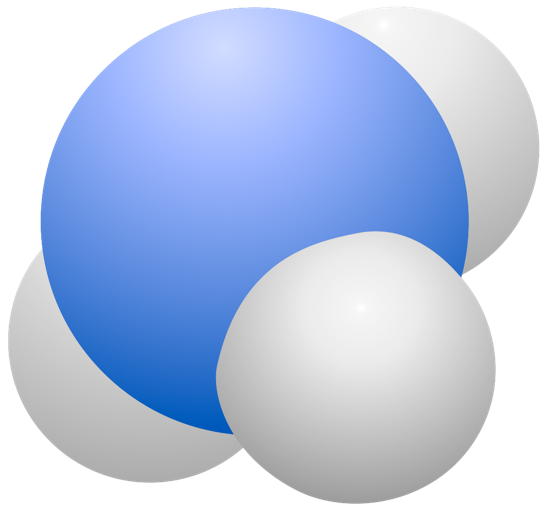

On dénombre 6 éléments de symétrie dans le groupe :

- on peut tout laisser à l’identique (élément neutre) ,

- on peut permuter circulairement les orbitales $\mathrm{s}_i$ des hydrogènes dans un sens ou dans l’autre : $\mathrm{s}_1 \rightarrow \mathrm{s}_2 \rightarrow \mathrm{s}_3 \rightarrow \mathrm{s}_1$ , $\mathrm{s}_1 \rightarrow \mathrm{s}_3 \rightarrow \mathrm{s}_2 \rightarrow \mathrm{s}_1$,

- on peut permuter deux à deux les orbitales 1s, ça fait 3 possibilités.

On vérifie à nouveau l’isomorphisme entre $\boldsymbol{S_3}$ et $\boldsymbol{D_3}$ puisque si la molécule de $\ce{NH3}$ a les symétries de $\boldsymbol{S_3}$, elle a bien aussi celles du triangle équilatéral, groupe $\boldsymbol{D_3}$ (mêmes transformations invariantes : l’identité, les 2 rotations $2\pi/3$ et $-2\pi/3$, et les 3 réflexions par rapport aux hauteurs).

L’atome d’azote est, lui, toujours laissé invariant.

On peut partir de la table de multiplication de ce groupe (voir chapitre précédent) pour construire certaines représentations.

- Représentations de dimension 1 :

- La table est respectée par une première représentation de dimension 1 plutôt triviale consistant à associer le nombre 1 à chaque élément du groupe.

- Une autre représentation de dimension 1 un peu plus intéressante consiste à représenter les rotations par des $1$ et les réflexions par des $-1$.

Une rotation suivie d’une rotation donne bien une autre rotation ($1\times 1=1$), de même qu’une réflexion suivi d’une autre réflexion ($(-1)\times (-1)=1$), alors que les compositions croisées correspondent effectivement toutes à des réflexions ($1\times(-1)=-1$). - En munissant le plan d’un repère orthonormé, on peut aussi écrire les matrices 2×2 de chacune des transformations et obtenir ainsi une représentation de dimension 2 :

-

l’identité est alors représentée par :

$$ \left(\begin{array}{ll} 1 & 0 \\ 0 & 1 \end{array}\right) $$

-

les deux permutations circulaires (ou rotation de $\pm2\pi/3$) par :

$$ \left(\begin{array}{cc} \cos (2 \pi / 3) & -\sin (2 \pi / 3) \\ \sin (2 \pi / 3) & \cos (2 \pi / 3) \end{array}\right), \left(\begin{array}{cc} \cos (4 \pi / 3) & -\sin (4 \pi / 3) \\ \sin (4 \pi / 3) & \cos (4 \pi / 3) \end{array}\right) $$

-

et les 3 permutation deux à deux (réflexions) par :

$$ \left(\begin{array}{cc} 1 & 0 \\ 0 & -1 \end{array}\right), \left(\begin{array}{cc} \cos (2 \pi / 3) & \sin (2 \pi / 3) \\ \sin (2 \pi / 3) & -\cos (2 \pi / 3) \end{array}\right), \left(\begin{array}{cc} \cos (4 \pi / 3) & \sin (4 \pi / 3) \\ \sin (4 \pi / 3) & -\cos (4 \pi / 3) \end{array}\right) $$

- On aurait aussi pu simplement partir de la base formée des 4 orbitales ($\mathrm{s_N}$, $\mathrm{s_1}$, $\mathrm{s_2}$, $\mathrm{s_3}$) et regarder ce qu’il advient de chacune. On obtient alors une représentation de dimension 4 de ce groupe de transformations :

-

l’identité s'écrit ainsi :

$$ \left(\begin{array}{llll} 1 & 0 & 0 & 0 \\ 0 & 1 & 0 & 0 \\ 0 & 0 & 1 & 0 \\ 0 & 0 & 0 & 1 \end{array}\right) $$

-

les deux permutations circulaires (ou rotations) :

$$ \left(\begin{array}{llll} 1 & 0 & 0 & 0 \\ 0 & 0 & 0 & 1 \\ 0 & 1 & 0 & 0 \\ 0 & 0 & 1 & 0 \end{array}\right) , \left(\begin{array}{llll} 1 & 0 & 0 & 0 \\ 0 & 0 & 1 & 0 \\ 0 & 0 & 0 & 1 \\ 0 & 1 & 0 & 0 \end{array}\right) $$

-

et les 3 permutation deux à deux (réflexions) :

$$ \left(\begin{array}{llll} 1 & 0 & 0 & 0 \\ 0 & 1 & 0 & 0 \\ 0 & 0 & 0 & 1 \\ 0 & 0 & 1 & 0 \end{array}\right) , \left(\begin{array}{llll} 1 & 0 & 0 & 0 \\ 0 & 0 & 0 & 1 \\ 0 & 0 & 1 & 0 \\ 0 & 1 & 0 & 0 \end{array}\right) , \left(\begin{array}{llll} 1 & 0 & 0 & 0 \\ 0 & 0 & 1 & 0 \\ 0 & 1 & 0 & 0 \\ 0 & 0 & 0 & 1 \end{array}\right) $$

Cet exemple illustre le bazar que le monde des représentations peut vite devenir…

On va voir comment ranger tout ça en regroupant les représentations par classe et surtout en décomposant les représentations d’un groupe en représentations irréductibles, atomes de la théorie.

Réductibilité et irréductibilité

Pour la plupart des groupes susceptibles d’intéresser un physicien, les diverses façon de les représenter sont limitées et peuvent être répertoriées. Cela structure fortement l’espace vectoriel dans lequel joue le système physique.

Afin de classer les représentations, il faut d’abord être sûr qu’elles sont bien différentes. Pour cela, il faut vérifier qu’elles n’appartiennent pas à la même classe d’équivalence :

Soit $U(G)$ est une représentation du groupe $G$ sur l’espace vectoriel $V$ et $S$ n’importe quelle opérateur inversible sur $V$.

Alors la représentation $U^{\prime}(G)$ telle que $U^{\prime}(G)=S U(G) S^{-1}$ (les matrices associées sont alors semblables) forme aussi une représentation de $G$ sur $V$, de même dimension. On dit que $U(G)$ et $U^{\prime}(G)$ sont équivalentes (on note alors $U \sim U^{\prime}$).

Et l’ensemble des représentations équivalentes forme une classe d’équivalence. Il suffit de connaître un élément de chaque classe puisqu’on peut générer tous les autres à partir de celui-ci.

On n’a fait là qu’importer la notion de classes des groupes aux représentations.

Pour répertorier les différentes représentation d’un groupe, on se concentre donc sur les représentations non équivalentes.

Et pour s’assurer que deux représentations sont équivalentes ou non, il faut une grandeur variant d’une classe à l’autre mais pas à l’intérieur d’une classe. On appelle une telle quantité un invariant de similitude (puisqu’il est identique pour deux matrices semblables). La trace en est un (ça lui donne d’ailleurs son nom : indépendante d’un changement de base, la trace caractérise la matrice) !

Mais chez les représentations, le vocabulaire s’enrichit :

Le caractère $\chi(G)$ d’un élément de $G$ dans une représentation $U(g)$ est défini comme $\chi(g)=\operatorname{Tr} U(g)$. Tous les éléments du groupe d’une même classe ont le même caractère.

Le caractère caractérise donc une classe.

Les différentes représentations équivalentes sont autant de doublons à balayer mais une autre redondance pollue aussi l’analyse : une représentation donnée peut être décrite comme la somme de ses sous-parties.

Supposons que l’on ait deux représentations $U_1(G)$ et $U_2(G)$ dans deux espaces orthogonaux $V_1$ et $V_2$. On peut alors construire une nouvelle représentation dans l’espace somme directe de $V_1$ et $V_2$ : $V_1 \oplus V_2$. La représentations est alors dite somme directe des représentations : $U(G)=U_1(G) \oplus U_2(G)$. Chacun des deux sous-espaces reste invariant sous l’action de $U$ par construction (on dit plutôt qu’ils sont laissés stables).

C’est l’opération inverse qui va nous intéresser : quand une représentation donnée peut être décomposée en sous-représentations laissant stables certains sous-espaces. La représentation est alors dites réductibles.

Précisons le vocabulaire :

Un sous-espace $V_1$ de $V$ est dit stable par l’action de $U(G)$ si pour tout $g\in G$, et pour tout $x \in V_1$, $U(g) x \in V_1$.

Une représentation $U(G)$ sur $V$ est dite irréductible s’il n’y a pas dans $V$ de sous-espace laissé stable par l’action de $U(G)$.

Si un tel sous-espace invariant existe et si le sous-espace orthogonal est aussi invariant, alors la représentation est dite complètement réductible.

c’est le cas des représentations du groupe des translations à une dimension :

$D(a)=\left(\begin{array}{ll} 1 & a \\ 0 & 1 \end{array}\right)$

Elle laisse invariant tout vecteur $(x,0)$ mais n’a pas de sous-espace supplémentaire invariant (tentons par exemple $(0,1)$ comme sous-espace complémentaire, on se retrouve avec $D(a)(0,1)=\binom{a}{1}$ qui n’appartient pas au sous-espace $\{(0,1)\}$ (sauf pour $a=0$).

Représentation unitaire

Une représentation unitaire $U(g)$ est définie sur un espace vectoriel muni d’un produit scalaire (donnant une norme définie positive). Un tel espace est dit préhilbertien.

La représentation unitaire doit respecter $U^{\dagger} U=1$ (où $U^\dagger$ est l’opérateur adjoint de $U$). Elle préserve les longueurs, les angles et le produit scalaire, et est donc naturellement associée aux transformations de symétrie (d’où son intérêt).

Techniquement, une représentation $U(g)$ sur un espace préhilbertien $V$ est unitaire si pour tout $g\in G$, $\langle U(g) x \mid U(g) y\rangle=\langle x \mid y\rangle$ pour tout $x,y \in V$, avec $\langle x \mid y\rangle$ désignant le produit scalaire entre les vecteurs $|x\rangle$ et $|y\rangle$.

On peut retrouver le lien entre représentation unitaire et opération de symétrie en partant d’un état physique quelconque :

Soit $|\psi\rangle$ un «vecteur d’état» d’un système sur un espace vectoriel d’états physiques. Une opération de symétrie transforme $|\psi\rangle$ en $|\psi^\prime\rangle$. Les deux ensembles de vecteurs $\{|\psi\rangle\}$ et $\{|\psi^\prime\rangle\}$ doivent fournir des descriptions équivalentes du système physique ce qui implique que l’opérateur de symétrie soit linéaire.

De plus, toute observable physique doit rester invariante sous la transformation or ces observable sont toujours exprimées sous la forme de produits scalaires du type $\langle\phi \mid \psi\rangle$. Et des transformations linéaires qui préservent le produit scalaire sont induites par des opérateurs unitaires !

Les représentations unitaires ont une propriété remarquable qui va beaucoup nous occuper :

Si une représentation unitaire est réductible alors elle est complètement réductible.

Soit $U(G)$ une représentation unitaire réductible sur $G$ et soit $V_1$ un sous-espace stable par l’action de $U(G)$, et $V_2$ le complément orthogonal à $V_1$. Il faut montrer que $V_2$ est lui aussi stable par l’action de $U(G)$.

Quels que soient $x\in V_1$ et $y\in V_2$,

$$ \begin{aligned} \langle x \mid U(g) y\rangle & =\left\langle U\left(g^{-1}\right) x \mid U\left(g^{-1}\right) U(g) y\right\rangle \\ & =\left\langle U\left(g^{-1}\right) x \mid U^{-1}(g) U(g) y\right\rangle \\ & =\left\langle U\left(g^{-1}\right) x \mid y\right\rangle=0 \end{aligned} $$

car $U\left(g^{-1}\right) x \in V_1$ comme $U(g)(x)$.

Par conséquent $U(g)y$ appartient à l’espace orthogonal à $V_1$, c’est-à-dire $V_2$, et ce pour tout $g\in G$.

Conclusion, l’espace $V_2$ est stable sous l’action de $G$.

Donc une représentation unitaire pourra toujours s’écrire comme la somme directe de ses représentations irréductibles et non équivalentes (des représentations équivalentes vivent dans le même sous-espace) :

$$ \begin{aligned} U(G)&=\underbrace{U^1(G) \oplus \cdots \oplus U^1(G)}_{n_1\text{ termes}} \oplus \underbrace{U^2(G) \oplus \cdots \oplus U^2(G)}_{n_2\text{ termes}} \oplus \cdots\\ &=\sum_{\mu \oplus} n_\mu U^\mu(g) \end{aligned} $$

où $n_\mu$ est le nombre de fois que la représentation irréductible $\mu$ apparaît dans la décomposition.

Tout ce qui va suivre découle de cette décomposition…

Avec le bon choix de base, les matrices de la représentation $U(g)$ apparaîtront donc diagonales par bloc.

$$ D(g)=\left(\begin{array}{cccc} D^1(g) & 0 & \cdots & 0 \\ 0 & D^2(g) & \cdots & \vdots \\ \vdots & \vdots & \ddots & \vdots \\ 0 & 0 & \cdots & D^k(g) \end{array}\right) $$

Pour tout $g,g^\prime \in G$,

$$ D(g) D(g^{\prime})=\left(\begin{array}{cccc} D^1(g) D^1(g^{\prime}) & 0 & \cdots & 0 \\ 0 & D^2(g) D^2(g^{\prime}) & \cdots & \vdots \\ \vdots & \vdots & \ddots & \vdots \\ 0 & 0 & \cdots & D^k(g) D^k(g^{\prime}) \end{array}\right) $$

Le non croisement des termes montre que $D(G)$ ne contient pas de nouvelles informations par rapport à l’ensemble des $D_i(G)$ justifiant que l’on puisse parler de redondance entre une représentation et l’ensemble de ses représentations irréductibles.

Cette décomposition n’est a priori possible que pour des représentations unitaires mais c’est finalement peu restreignant car outre le fait que les groupes de symétrie qui intéressent le physicien sont naturellement associés à des transformations unitaires, toute représentation d’un groupe fini ou compact (éléments variant sur un espace compact) est équivalente à une représentation unitaire.

En effet, toute représentation d’un groupe fini sur un espace doté d’un produit scalaire est équivalent à une représentation unitaire.

À partir du produit scalaire $\langle x \mid y\rangle$ défini sur l’espace vectoriel $V$, on en construit un nouveau, toujours sur $V$, en opérant une sorte de moyennage sur l’action du groupe $G$ (cette astuce de passage par la moyenne va beaucoup nous servir) :

$(x, y) \equiv \sum_g\langle D(g) x \mid D(g) y\rangle$

$(.\,,.)$ a bien les propriétés d’un produit scalaire : bilinéaire, symétrique, positif, défini.

Passons maintenant de la base orthonormée $\{e_i\}$ adaptée à l’ancien produit scalaire, telle que $\left\langle e_i \mid e_j\right\rangle=\delta_{i j}$ à une base $\{f_i\}$ adaptée au nouveau, telle que $\left(f_i, f_j\right)=\delta_{i j}$. Soit $S$ la matrice de changement de base : $f_i=S_i^{\,j} e_j$.

On a ainsi : $(x, y)=\langle S x \mid S y\rangle$ pour tout $x$ et $y$ dans $V$.

La représentation $U(g)=S D(g) S^{-1}$, équivalente à $D(g)$, est alors unitaire.

En effet :

La preuve précédente est généralisable aux groupes compacts en remplaçant la somme dans la moyenne par une intégrale mais ça devient un peu plus technique.

Savoir qu’une représentation est réductible nous fait une belle jambe tant qu’on ne sait pas distinguer une représentation déjà réduite d’une représentation pouvant l’être. Car si la matrice associée n’a pas le bon goût d’être d’ores et déjà diagonale par bloc, comment fait-on ? Et quand s’arrête-t-on d’essayer de réduire ?

Une propriété capitale de la théorie des représentations va nous donner les clés pour opérer cette diagonalisation par bloc jusqu’au bout : les représentations irréductibles froment une base orthonormée de l’espace des représentations du groupe.

Conditions d’orthonormalité et de complétude pour les représentations irréductibles

On obtient de haute lutte les relations suivantes :

- Une condition d’orthonormalité entre les représentations irréductibles (le «produit scalaire» entre deux représentations irréductibles identiques vaut 1, c’est ce qu’on nomme normalité, et est nul dans les autres cas, c’est l’orthogonalité) :

$\displaystyle \frac{n_\mu}{n_G} \sum_g D_\mu^{\dagger}(g)^k_i \, D^\nu(g)^j_l=\delta^\nu_\mu \, \delta^j_i \,\delta^k_l$

- Et une conditions de complétude (le mot a beau sonné vilain, il traduit que le pavage de l’espace des représentations par les morceaux irréductibles est complet) :

$\displaystyle \sum_{\mu, l, k} \frac{n_\mu}{n_G} D^\mu(g)^l_k \, D_\mu^{\dagger}\left(g^{\prime}\right)^k_l=\delta^g_{g^{\prime}}$

- Le caractère complet est démontré par la très importante ultime relation :

$\displaystyle\sum_\mu n_\mu^2=n_G$

Les conditions d’orthonormalité sont élevées au rang de Great Orthogonality Theorem (GOT) chez les anglo-saxons.

On peut les réécrire en notant à la manière quantique $\langle g \mid \nu, j, l\rangle=\sqrt{\frac{n_\nu}{n_G}} D^\nu(g)^j_l$ pour insister sur la nature «vectorielle» de ces relations :

$$\displaystyle\sum_g\langle\mu, i, k \mid g\rangle\langle g \mid \nu, j, l\rangle=\delta^\nu_\mu \,\delta^j_i \, \delta^k_l$$

Cette forme permet d’appréhender plus facilement son interprétation géométrique. Il faut s’imaginer un espace vectoriel complexe à $n_G$ dimensions où chaque axe correspond à un élément du groupe.

Chaque $D^\mu(g)^j_i$ peut donc être vues comme un «vecteur» à $n_G$ composantes (avec $g$ parcourant $G$), tous orthogonaux entre eux. Le premier de ces vecteurs serait par exemple :

$ \left(D^1(e)^1_1, D^1\left(g_1\right)^1_1, D^1\left(g_2\right)^1_1, \ldots, D^1\left(g_{n_G}\right)^1_1\right) $

On peut aussi réécrire à la manière quantique la relation de complétude :

$$\sum_{\mu, l, k}\langle g \mid \mu, l, k\rangle\left\langle\mu, l, k \mid g^{\prime}\right\rangle=\delta^g_{g^{\prime}}$$

On s’applique en mécanique quantique à vérifier des relations du même type sur les vecteurs de base de l’espace vectoriel des états (c’est d’ailleurs une des motivations pour la notation compacte en bra-ket adoptée ici). Mais au terme «complétude», les quanticiens préfèrent la mieux tournée «relation de fermeture» dont le contenu est le même ; il s’agit de prouver que l’espace ainsi décomposé est complet, c’est-à-dire que tout état peut se décomposer sur les vecteurs de base.

La démonstration de l’orthonormalité s’appuie sur le lemme de Schur qu’on va détailler tout de suite (les relations précédentes sont d’ailleurs parfois appelées relations d’orthogonalité de Schur) et la complétude repose sur les représentations régulières qu’on décrira plus loin.

Opérateur d’entrelacement

Avant d’arriver au lemme de Schur, il nous faut introduire un nouvel opérateur qui généralise la notion d’homomorphisme d’une représentation à une autre.

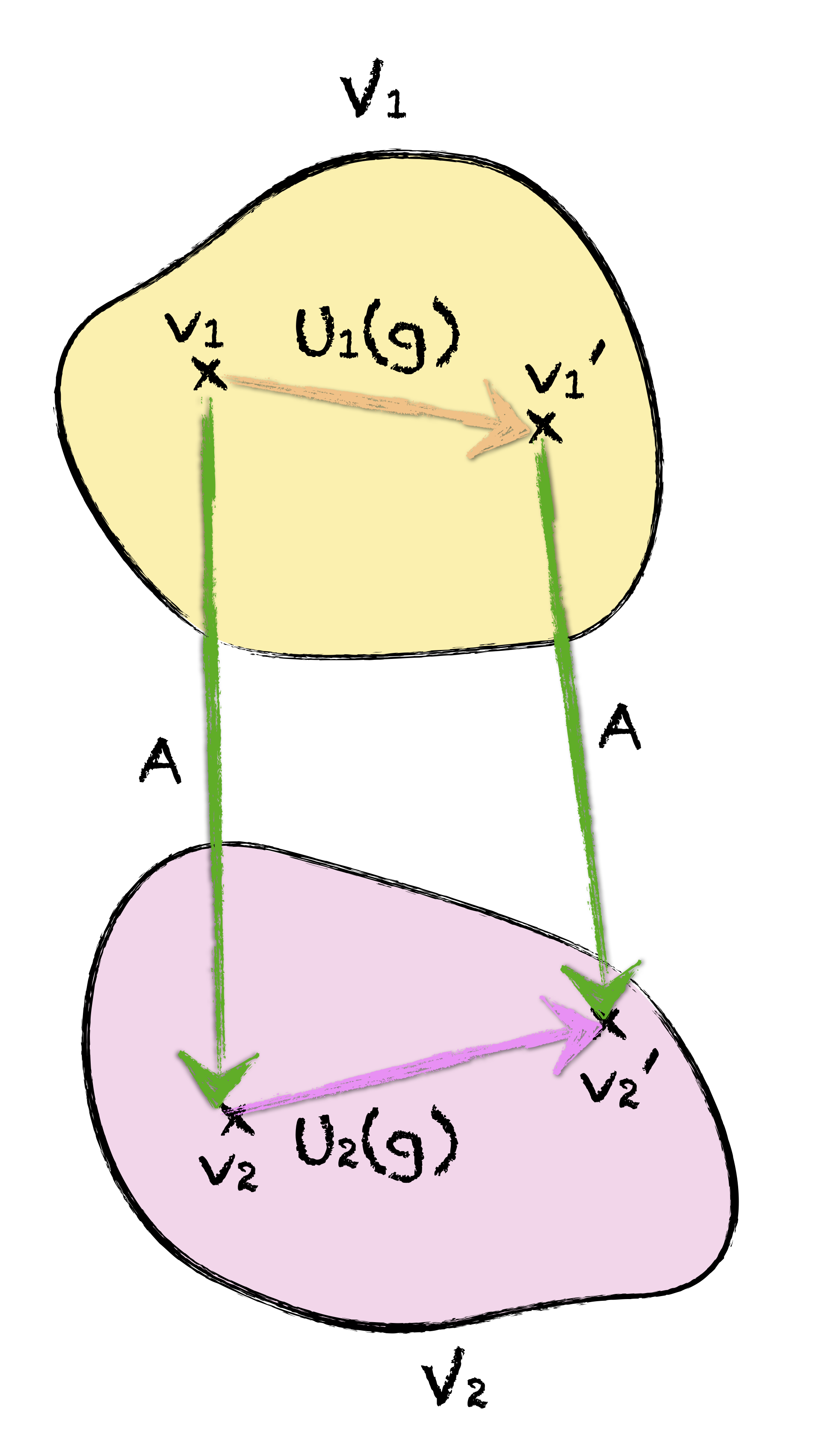

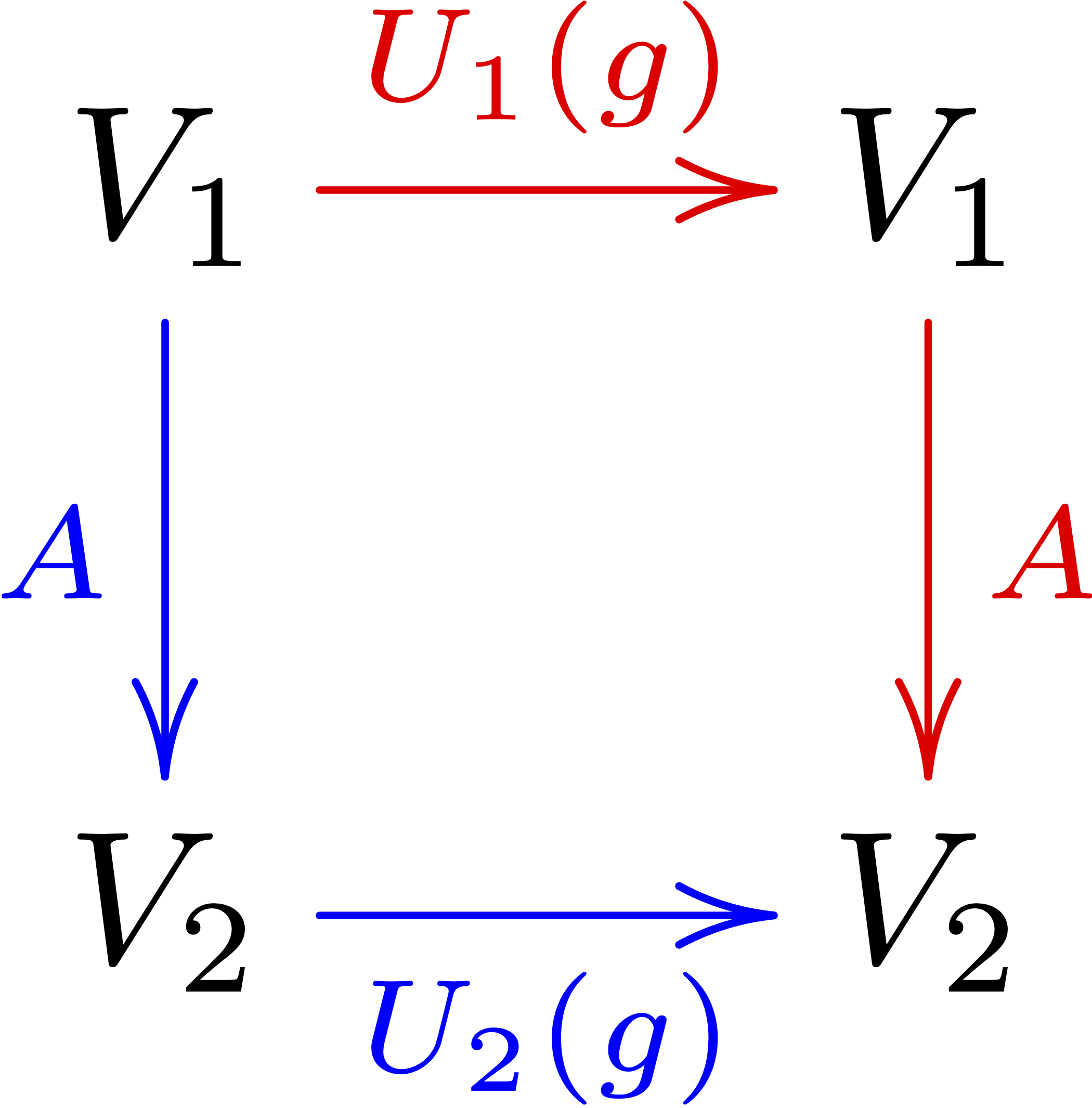

Prenons une représentation $U_1(G)$ d’un groupe $G$ dans un espace vectoriel $V_1$ envoyant un vecteur $v_1$ quelconque vers un vecteur $v^\prime_1$ pour un certain élément $g$ de $G$ et une représentation $U_2(G)$ du même groupe $G$ dans un espace $V_2$ envoyant un vecteur $v_2$ vers un vecteur $v^\prime_2$ toujours pour le même élément $g$. On aimerait qu’un homomorphisme $A$ de l’une à l’autre de ces représentations conserve leurs actions en associant parallèlement les vecteurs modifiés pour chaque $g$.

Pour être plus clair : si $A$ envoie $v_1$ sur $v_2$, on voudrait alors du même coup que $v^\prime_1$ soit envoyé sur $v^\prime_2$.

On aurait ainsi $v_2^{\prime}=U_2(g) v_2=U_2(g) A v_1=A v_1^{\prime}=A U_1(g) v_1$.

Formalisons :

Soient $U_1(G) \in V_1$ et $U_2(G) \in V_2$ deux représentations. L’opérateur d’entrelacement $A$ (ou homomorphisme de représentations) est une application linéaire de $V_1$ sur $V_2$ tel que $A U_1(g)=U_2(g) A$ pour tout $g\in G$.

On dit que $A$ entrelace $U_1$ et $U_2$ ce qui est plutôt mignon.

On dit aussi que $A$ est une application G-équivariante, sobriquet assez parlant bien que moins poétique.

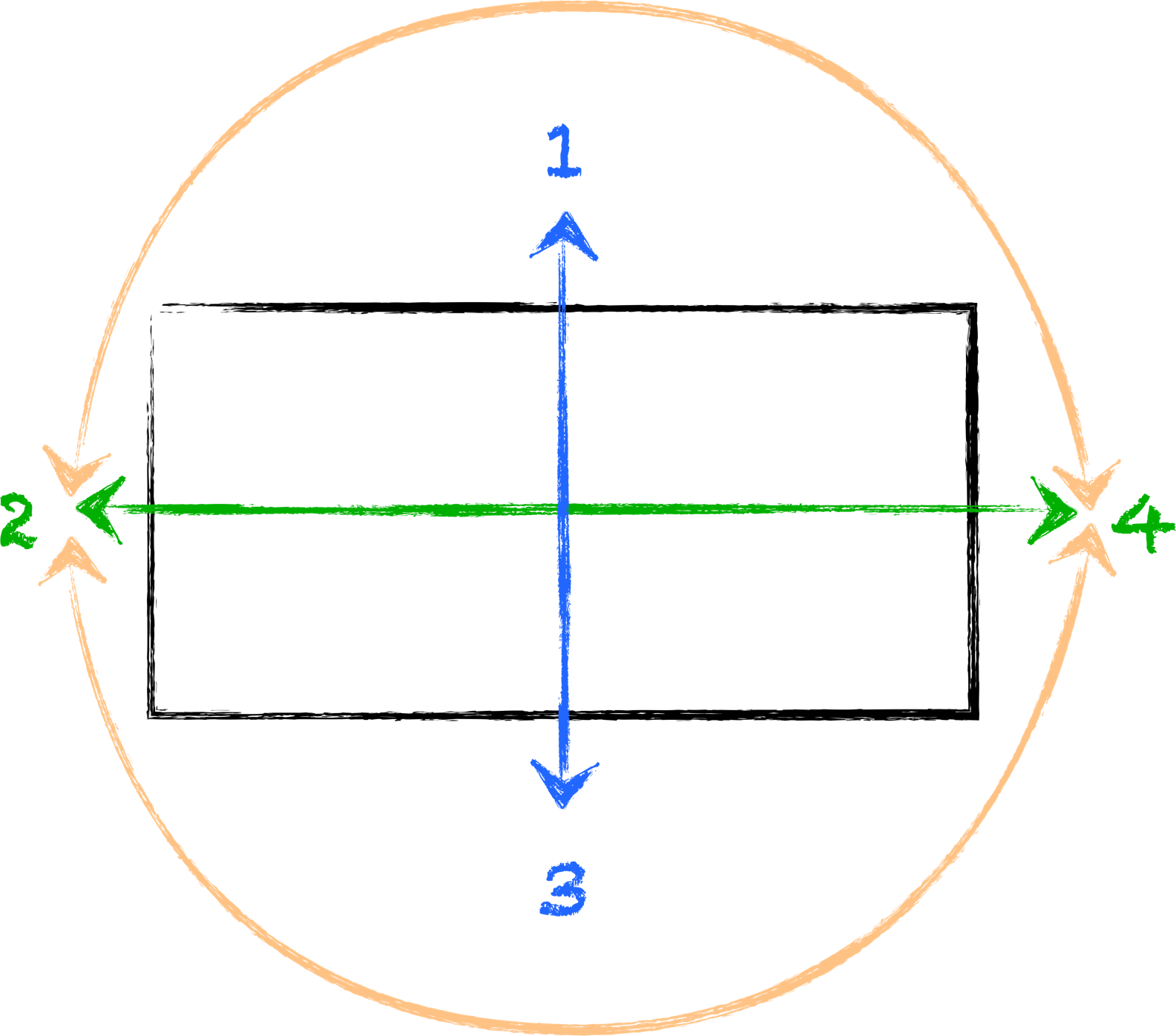

Et pour les esprits schématiques, l’opérateur d’entrelacement peut aussi être définit tel que le diagramme suivant commute pour tout $g\in G$, le chemin rouge et le chemin bleu arrivant au même endroit :

L’ensemble de tous les opérateurs d’entrelacement de $U_1$ à $U_2$ est noté $\operatorname{Hom}_G\left(U_1, U_2\right)$.

Lemme de Schur

Soit $U_1(G)$ et $U_2(G)$ deux représentations irréductible d’un groupe $G$ sur des espaces vectoriels $V_1$ et $V_2$ et $A \in \operatorname{Hom}_G\left(U_1, U_2\right)$, un opérateur d’entrelacement.

On a alors : soit $A=0$, soit $V_1$ et $V_2$ sont isomorphes et les représentations $U_1$ et $U_2$ sont équivalentes.

Si $A=0$, il n’y a rien à démontrer. Supposons alors $A≠0$.

- Montrons que $A$ est surjectif :

comme $A≠0$, il existe au moins deux vecteurs $v_2$ et $v_1$ respectivement de $V_2$ et $V_1$ tels que $v_2=A v_1$.

Et pour tout $g\in G$, on a : $U_2(g) v_2=U_2(g) A v_1=A\left(U_1(g) v_1\right)$ qui appartient à $A V_1$.

Par conséquent, $A V_1$ est un sous-espace stable non nul de $V_2$ par rapport à $U_2$ et comme $U_2$ est irréductible, on doit avoir $AV_1 = V_2$ . - Montrons que $A$ est injectif :

soit maintenant $W$ le noyau de $A$. $A$ est une application linéaire, or le noyau d’une application linéaire change un tantinet de ceux côtoyés jusqu’ici puisque l’élément neutre n’est plus l’identité mais le vecteur nul (la composition interne considérée est l’addition). Le noyau étant définit comme l’ensemble aboutissant à l’élément neutre, on a $W=\left\{v_1 \in V_1 ; A v_1=0\right\}$.

Prenons un élément $v_1$ de ce noyau. Alors $A\left(U_1(g) v_1\right)=U_2(g) A v_1=U_2(g) 0=0$, donc $U_1(g) v_1$ appartient à $W$ et ce, pour tout $g$. Ce qui implique que $W$ est un sous-espace invariant de $V_1$ pour $U_1$, or comme $U_1$ est irréductible, soit $W=V_1$ mais alors $A=0$, soit $W=\{0\}$ (injection).

$A$ est donc une application bijective entre $V_1$ et $V_2$, ce qui implique que ces deux espaces soient isomorphes.

D’autre part, comme le noyau de $A$ est le vecteur nul, $A$ est inversible et de $U_2(g) A v_1=A\left(U_1(g) v_1\right)$, on déduit $U_2(g)=A U_1(g) A^{-1}$ pour tout $g\in G$.

Les deux représentations sont bien équivalentes.

On tire un intéressant corollaire du lemme de Schur :

Soit $U(G)$ une représentation irréductible et de dimension finie de $G$ dans l’espace vectoriel $V$ complexe. Alors, un homomorphisme de la représentation de $U$ sur elle-même (automorphisme appartenant à $\operatorname{Hom}_G(U, U)$) est un multiple de la matrice identité $E$.

soit $A$ un opérateur de cet homomorphisme et soit une valeur propre $λ \in \mathbb{C}$ de $A$ (comme $A$ est inversible et de dim finie sur un espace vectoriel complexe, il y en a forcément au moins une). $A- λE$ appartient aussi à l’automorphisme puisque $E$ en fait partie et qu’on joue avec des applications linéaires (la loi de composition de groupe, si on peut encore l’appeler ainsi, est justement la combinaison linéaire d’éléments).

Mais par définition d’une valeur propre, $A- λE$ n’est pas inversible donc d’après le lemme, il ne peut s’agir que de l’élément nul (le lemme dit : soit isomorphisme soit zéro).

Remarque :

C’est la première fois qu’on s’impose de travailler sur un espace vectoriel complexe. Lui-seul permet d’affirmer qu’un opérateur linéaire sur un espace vectoriel de dimension finie possède une valeur propre. C’est une conséquence de l’existence d’une racine pour tout polynôme de degré ≥ 1 dans $\mathbb{C}$ (le théorème fondamental de l’algèbre dit bien qu’un polynôme de degré $n$ a $n$ racines). En particulier, le polynôme caractéristique de l’opérateur a donc une racine.

Et cela marche aussi pour un espace vectoriel complexe de dimension infinie mais clôt, ce qui permet d’étendre la propriété aux cas qu’on rencontrera dans les chapitres suivants.

Notons que l’automorphisme d’une représentations commute, par définition, avec tous les éléments de cette représentation.

Par conséquent, la propriété peut se reformuler ainsi :

Soit $U(G)$ une représentation irréductible d’un groupe $G$ dans un espace vectoriel $V$.

Un opérateur $A$ de $V$ commutant avec tous les opérateurs ${U(g), g \in G}$ est un multiple de l’identité.

On utilise cette propriété pour débusquer les opérateurs de Casimir comme $\overrightarrow{J^2}$ (d’Henrik Casimir, physicien hollandais).

Et on en déduit aussi (corollaire du corollaire) :

Toute représentation irréductible d’un groupe abélien est de dimension 1.

Soit $U(G)$ une représentation irréductible du groupe abélien $G$. Soit $p$ un élément de $G$. Comme $G$ est abélien, on a $U(p) U(g)=U(g) U(p)$ pour tout $g\in G$.

D’après le lemme de Schur, on a alors $U(p)=\lambda_p E$. Et cela marche pour tout les $p\in G$. Par conséquent, la représentation $U(G)$ est équivalente à la représentation unidimensionnelle $p \rightarrow \lambda_p \in \mathbb{C}$ pour tous les $p\in G$.

En physique, ces considérations généralisent un résultat bien connu : des opérateurs qui commutent possèdent un jeu complet de vecteurs propres communs (cf. la recherche d’un «ECOC», ensemble complet d’observables qui commutent, en mécanique quantique).

Précisons cela dans le cas de l’Hamiltonien.

La dynamique d’un système physique est déterminée par un opérateur appelé l’Hamiltonien $H$ et cet opérateur doit, par définition, rester invariant sous les opérations de symétrie laissant invariant le système physique lui-même.

Mathématiquement, cela revient à dire que $H$ commute avec les opérateurs unitaires de la symétrie considérée. Et par conséquent, dans une représentation irréductible donnée du groupe de symétrie, l’Hamiltonien a pour représentation un multiple de la matrice identité.

En d’autres mots, tous les vecteurs de la représentation irréductible sont des vecteurs propres de l’Hamiltonien pour la même valeur propre.

Cette valeur propre de l’Hamiltonien n’est autre que l’énergie du système et donc l’ensemble des états symétriques qu’on obtient (les vecteurs de la représentation irréductible) sont à énergie fixée.

Démonstration de l’orthonormalité

On est maintenant armé pour prouver l’orthonormalité des représentations irréductibles :

Soit $X$ une matrice $n_\mu \times n_\nu$ quelconque à partir de laquelle on forme :

$M_X=\sum_g D_\mu^{\dagger}(g) X D^\nu(g)$ où $D_\mu(g)$ (resp. $D_\nu(g)$) est une matrice de la représentation irréductible unitaires de $G$ d’ordre $\mu$ (resp. $\nu$). L’unitarité implique $D_\mu^{\dagger}(g)=D_\mu^{-1}(g)$.

En découle :

D’après le lemme de Schur, soit $\mu≠\nu$ (les deux représentations ne sont pas équivalentes) et alors $M_X = 0$, soit $\mu=\nu$ et $M_X=c_X E$ avec $c_X$ une constante (car on est dans le cas de l’automorphisme).

Choisissons $X$ parmi les $n_\mu \times n_\nu$ matrices $X_l^k\left(k=1, \cdots, n_\nu ; l=1, \cdots, n_\mu\right)$ dont les éléments sont définis par : $\left(X_l^k\right)^i_j=\delta_j^k \delta_l^i$.

Prenons un exemple pour fixer les idées, avec $n_\nu=4$ et $n_\mu=3$, $X^1_2$ s’écrit :

$X_2^1=\left(\begin{array}{llll}

0 & 0 & 0 & 0 \\

1 & 0 & 0 & 0 \\

0 & 0 & 0 & 0\\

\end{array}\right)$

Un seul élément de chaque $X^k_l$ est non nul (et vaut 1), celui se trouvant colonne $k$, ligne $l$.

On a alors :

$\left(M_l^k\right)^i_j=\sum_g D_\mu^{\dagger}(g)^i_m\left(X_l^k\right)^m_n D^\nu(g)^n_j=\sum_g D_\mu^{\dagger}(g)^i_l D^\nu(g)^k_j$ qui doit être nul dans le cas $\mu≠\nu$, expliquant le terme $\delta^\mu_\nu$ dans la relation à démontrer.

Et dans le cas $\mu=\nu$, $\left(M_l^k\right)^i_j=c_l^k \,\delta_j^i$ où les $c_k^l$ sont des constantes.

On détermine la valeur de ces constantes en prenant la trace de chacun des membres de l’équation ($i=j$) :

pour le membre de gauche, on obtient $n_\mu c_l^k$ et pour le membre de droite $\sum_g\left[D_\mu^{\dagger}(g) D^\mu(g)\right]_l^k=n_G \delta_l^k$.

Finalement, $c_l^k=\left(n_G / n_\mu\right) \delta_l^k$.

Remarque :

l’orthonormalité entre représentations irréductibles inéquivalentes est insuffisante pour obtenir la relation $\Sigma_\mu n_\mu^2=n_G$.

En effet, en considérant les $D^\mu(g)_j^i$, $g \in G$ comme un ensemble de vecteurs orthogonaux étiquetés par les $(\mu,i,j)$, on se retrouve avec $\Sigma_\mu n_\mu^2$ «vecteurs» dans cet ensemble puisque les $(i,j)$ prennent $n_\mu^2$ valeurs différentes et chacun de ces vecteurs est formé de $n_G$ composantes. Or le nombre de vecteurs mutuellement orthogonaux (donc linéairement indépendants) doit être au mieux égal à la dimension de l’espace vectoriel, ici $n_G$.

On a donc seulement $\sum_\mu n_\mu^2 \leq n_G$.

Cela rend néanmoins déjà possible la quête principale de la théorie des représentations : le recensement de toutes les représentations irréductibles non équivalentes d’un groupe donné.

Bien qu’anticipant la preuve, on sait déjà que l’inégalité est en réalité toujours saturée. Les «vecteurs» étiquetés par $(\mu,i,j)$ et formés de la collection ordonnée de $n_G$ $D^\mu(g)_j^i$, forment donc bien un ensemble complet en plus d’être orthogonal.

Applications de l’orthonormalité

Voyons maintenant comment utiliser l’orthogonalité pour construire de nouvelles représentations irréductibles.

$\mathrm{C}_2$, groupe le plus simple, a, comme tout les groupes, une représentations évidentes : l’identité $d_1$ définit comme $(e, a) \xrightarrow{d_1}(1,1)$ (notation signifiant $d_1(e)=1$ et $d_1(a)=1$). La notation réduite prend tout son sens avec la relation d’orthogonalité où les représentations sont vues comme des vecteurs). Si une deuxième représentation non équivalente $d_2$ est aussi regardé comme un vecteur a deux composantes, alors il doit être orthogonal à $(1,1)$. $(1,-1)$ est la seule possibilité à la fois orthogonale et normalisable. Donc le seul candidat pour une seconde représentation irréductible est $(e, a) \xrightarrow{d_2}(1,-1)$.

On ne peut trouver d’autres vecteurs orthogonaux, on a donc l’ensemble des représentation irréductibles de $\mathrm{C}_2$.

Partir de représentations simples comme l’identité est une des astuces.

Pour faire progresser l’investigation sur des groupes plus gros, on va avoir recours à une autre astuce liée aux groupes quotients mais cela va nous amener à digresser un peu…

Les groupes quotients fournissent de nouvelles représentations et permettent en outre de rendre fidèle une représentation dégénérée.

Représentations d’un groupe quotient :

Si un groupe $G$ a un sous-groupe invariant $H$ non trivial, alors toute représentation du groupe quotient $K=G/H$ est aussi une représentation de $G$, mais cette représentation de $G$ est dégénérée.

À l’inverse, si $U(G)$ est une représentation dégénérée de $G$, alors $G$ contient au moins un sous-groupe invariant $H$ tel que $U(G)$ définisse une représentation fidèle (non dégénérée) du groupe quotient $G/H$.

On a déjà vu que $\mathrm{S_3}$ a un sous-groupe invariant $H=\{e,(123),(321)\}$. Le groupe quotient est isomorphe à $\mathrm{C_2}=\{e,a\}$. Or $\mathrm{C_2} $ a une représentation assez simple $\{(e, a) \rightarrow(1,-1)\}$ (on reviendra plus loin sur ce type de notation et la méthode pour trouver une représentation autrement que par tâtonnement).

Cela induit une représentation unidimensionnelle de $\mathrm{S_3}$ associant $1$ aux éléments $\{e,(123),(321)\}$ et $-1$ à $\{(12),(23),(31)\}$. C’est effectivement une des possibilités trouvées dans l’exemple précédent en jouant avec la table de multiplication du groupe. Cette représentation, dégénérée pour $\mathrm{S_3}$, est bien une représentation fidèle pour $S_3 / H \simeq C_2$.

Remarque :

les représentations dégénérées et la manière de les rendre fidèle (ces choix sémantiques traduisent-ils une croisade morale de certains mathématiciens ?) reviendront sur le devant de la scène quand on parlera des groupes compacts (comme les rotations) et des topologies associées.

Ce nouvel outil peut faciliter grandement la recherche de représentations irréductibles comme on va le voir dans l’exemple suivant.

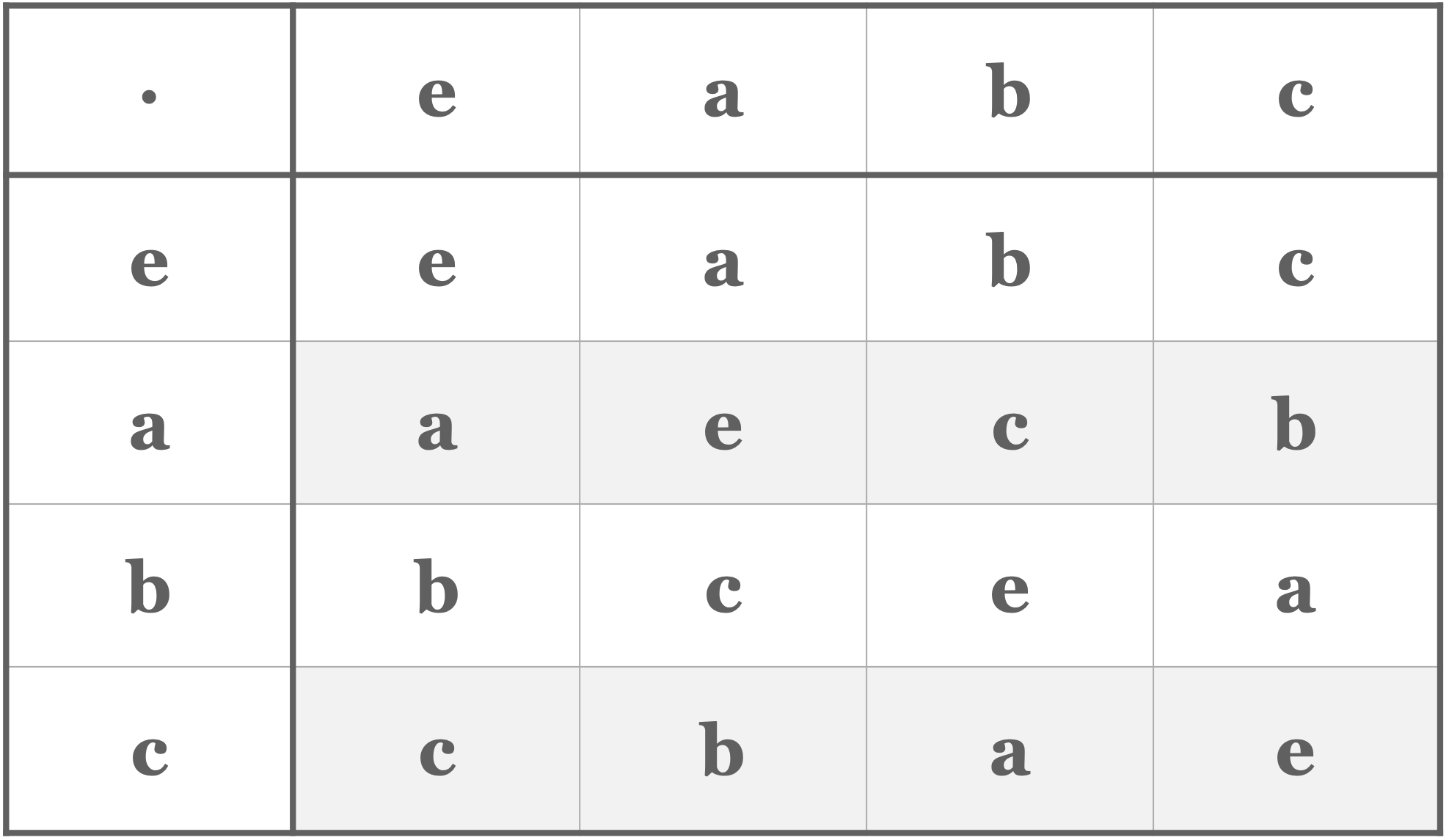

considérons le groupe dihédral $\mathrm{D_2}$ dont la table de multiplication est :

La première de ces représentations est la triviale identité : $(e, a, b, c) \xrightarrow{d_1}(1,1,1,1)$.

Maintenant, l’astuce : les éléments $\{e,a\}$ forment un sous-groupe invariant et le groupe quotient $\{\{e, a\},\{b, c\}\}$ est isomorphe à $\mathrm{C_2}$ (il n’y a qu’un groupe à deux éléments) dont on connait déjà les deux représentations irréductibles. Les deux représentations de $\mathrm{C_2}$ induisent deux représentations dégénérées sur $\mathrm{D_2}$. La première est la perpétuelle représentation identité, la deuxième associe $-1$ à $b$ et $c$ : $(e, a, b, c) \xrightarrow{d_2}(1,1,-1,-1)$.

On peut ensuite tenir le même raisonnement en partant du sous-groupe invariant $\{e,b\}$ qui nous amène la troisième représentation : $(e, a, b, c) \xrightarrow{d_3}(1,-1,1,-1)$.

Enfin, le sous-groupe invariant $\{e,c\}$ nous donne la quatrième et dernière : $(e, a, b, c) \xrightarrow{d_4}(1,-1,-1,1)$.

On vérifie bien que les 4 «vecteur» sont orthonornaux comme il se doit et qu’aucun autre ne peut exister par la même condition.

Remarques :

-

La relation $\Sigma_\mu n_\mu^2=n_G$ (que l’on démontrera plus loin) nous assure que pour tout groupe abélien (représentation unidimensionnelle $\Leftrightarrow n_\mu=1$), il y a autant de représentation que d’éléments ($n_G$) et les vecteurs formés par les représentations (étiquetés par $\mu$) forment alors un ensemble orthogonal complet.

Les représentations de $\mathrm{C_2}$ et $\mathrm{D_2}$ débusquées dans les exemples précédents illustrent bien ce point.

Plus besoin dans ce cas de guillemets au mot vecteur, il ne s’agit plus d’une collection pachydermique de $n_G$ objets de dimension $n_\mu^2$ mais bien d’une collection ordonnée de $n_G$ nombres qu’on désigne plus volontiers ainsi (ou des tenseurs de rang 1 si on veut fanfaronner), même si techniquement, les gros objets formés par une représentation quelconque peuvent tout autant revendiquer l’appellation. -

On s’intéressera dans les chapitres suivants à des groupes infinis et par chance, en dépit de quelques ajustements cosmétiques (les intégrales remplaceront les sommes discrètes), la condition d’orthonormalité des représentations irréductibles tient le choc.

Pour le groupe infini le plus simple, abélien et à une dimension, elle se confond avec le théorème de Fourier des fonctions périodiques et aiguise alors notre vision des choses ; la condition d’orthonormalité est en fin de compte une puissante extension du théorème de Fourier.

Comme on l’a déjà évoqué, les matrices des représentations dépendent de la base. Pour les représentations 1D des groupes abéliens, pas de soucis, mais chez les groupes plus complexes, les dimensions supplémentaires n’apporteront que tracas et confusion.

Grâce aux caractères, indépendants de la base, on pourrait maintenir un traitement équivalent aux douillettes représentations 1D quelle que soit la dimension. Transposer les relations d’orthonormalité chez les caractères, bien plus engageants, semble donc une entreprise judicieuse.

Conditions d’orthonormalité et de complétude pour les caractères irréductibles

Rappelons à toute fin utile que les caractères d’une représentation $U(G)$ sont les traces des opérateurs $U(g)$. Ils sont indépendant du choix de la base dans l’espace des représentations. Tous les éléments d’un groupe appartenant à une même classe ont par conséquent le même caractère dans une représentation donnée.

Soit $U^\mu(G)$ une représentation irréductible de $G$.

Alors la somme des $U^\mu(g)$ sur l’ensemble des éléments d’une classe donnée vaut :

$\sum_{h \in \zeta_i} U^\mu(h)=\frac{n_i}{n_\mu} \chi_i^\mu E$

où $\zeta_i$ est la classe $i$, $E$ l’opérateur identité, $n_\mu$ la dimension de la représentation et $n_i$ le nombre d’éléments dans la classe $i$.

Notons $A_i$ le membre de gauche de l’équation. On a alors $U^\mu(g) A_i U^\mu(g)^{-1}=A_i$ puisque le produit ne fait que réarranger l’ordre de la sommation (en utilisant le fait que si $h \in \zeta_i$, alors $g h g^{-1} \in \zeta_i$ pour tout $g\in G$). Donc $A_i$ commute avec toutes les représentations, ce qui, d’après le lemme de Schur, impose d’être proportionnel à l’opérateur identité : $A_i=c_i E$. On trouve $c_i$ en évaluant la trace des deux membres de l’équation. À gauche, ça donne $n_i \chi_i^\mu$, et à droite $c_i n_\mu$.

Ça va nous permettre de démontrer les relations d’orthonormalité et de complétude sur le groupe des caractères. Mais d’abord, énonçons-les…

Les caractères de représentations irréductibles non équivalentes d’un groupe $G$ satisfont les relations suivantes :

$$ \sum_i \frac{n_i}{n_G} \chi_\mu^{\dagger i} \chi_i^\nu=\delta_\mu^\nu \quad \text { orthonormalité } $$

$$ \frac{n_i}{n_G} \sum_\mu \chi_i^\mu \chi_\mu^{\dagger j}=\delta_i^j \quad \text { complétude } $$

où par convention $\chi_\mu^{\dagger i}=\left(\chi_i^\mu\right)^*$

Les $i$ courent sur les différentes classes du groupe et les $\mu$ sur les différentes représentations irréductibles non équivalentes.On part de la condition d’orthonormalité des représentations irréductibles en imposant $i=k$ et $k=l$ pour obtenir les traces.

À gauche, on obtient :

$$ \left(n_\mu / n_G\right) \sum_g \chi_\mu^{\dagger}(g) \chi^\nu(g)=\left(n_\mu / n_G\right) \sum_i n_i \chi_\mu^{\dagger i}(g) \chi_i^\nu(g) $$

Et à droite, on obtient $n_\mu \delta_\mu^\nu$.

Partons maintenant de la relation de complétude entre représentations irréductibles :

$$ \sum_{\mu, l, k} \frac{n_\mu}{n_G} D^\mu(g)_k^l D_\mu^{\dagger}\left(g^{\prime}\right)^k_l=\delta_{g g^{\prime}} $$

et sommons les $g$ parmi les éléments de la classe $\zeta_i$, et les $g^\prime$ parmi les éléments de la classe $\zeta_j$ :

$$ \sum_{\mu, l, k} \frac{n_\mu}{n_G} \sum_{g \in \zeta_i} D^\mu(g)_k^l \sum_{g^{\prime} \in \zeta_j} D_\mu^{\dagger}\left(g^{\prime}\right)^k_l=\sum_{g \in \zeta_i} \sum_{g^{\prime} \in \zeta_j} \delta_{g g^{\prime}} $$

On obtient :

$$ \sum_{\mu, l, k} \frac{n_\mu}{n_G} \frac{n_i}{n_\mu} \chi_i^\mu E_k^l \frac{n_j}{n_\mu} \chi_\mu^{\dagger j} E_l^k=\sum_{\mu, l, k} \frac{n_i n_j}{n_\mu n_G} \chi_i^\mu \chi_\mu^{\dagger j} E_k^l E_l^k $$

Or $\sum_{l, k} E^l_k E^k_l=\sum_l E_l^l=\operatorname{Tr} E=n_\mu$. D’où :

$$ \sum_{\mu, l, k} \frac{n_\mu}{n_G} \frac{n_i}{n_\mu} \chi_i^\mu E_k^l \frac{n_j}{n_\mu} \chi_\mu^{\dagger j} E_l^k=\sum_\mu \frac{n_i n_j}{n_G} \chi_i^\mu \chi_\mu^{\dagger j} $$