Principe de moindre action

Maupertuis propose le principe de moindre action en 1744 :

Lorsqu’il arrive quelque changement dans la nature, la quantité d’action, nécessaire pour ce changement, est la plus petite qui soit possible.

Il reprenait ainsi le flambeau de Fermat qui avait introduit dès 1657 le principe de moindre temps pour expliquer les trajets des rayons lumineux en optique géométrique.

Ces principes de parcimonie se révélèrent prémonitoires. La révolution quantique du 20e siècle plaça en effet l’action et surtout sa minimisation, au centre du jeu.

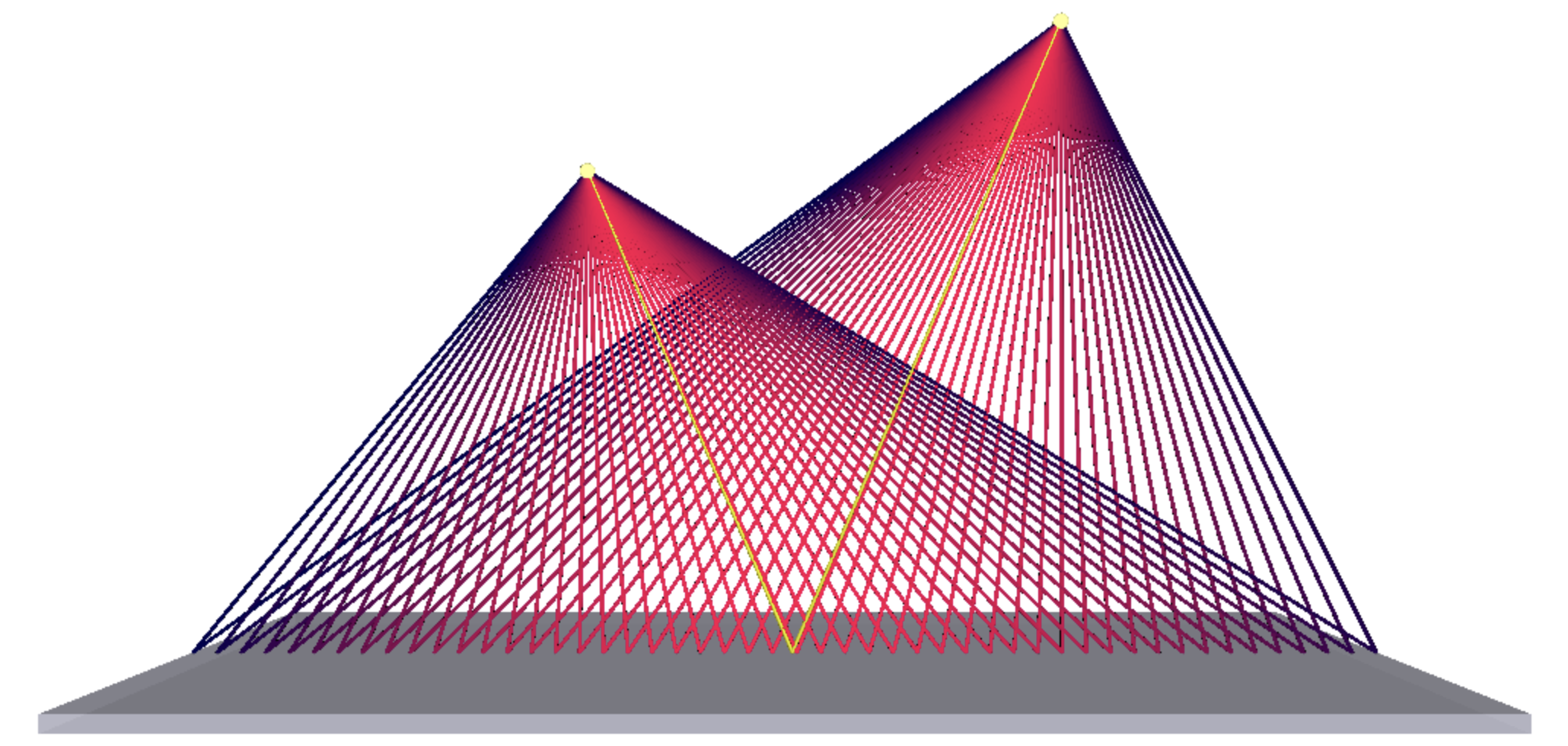

Reprenons l’idée de Fermat pour déterminer le chemin d’un rayon lumineux réfracté d’un milieu à l’autre. L’idée clé de cette manière de calculer par minimisation est de se donner un point de départ I et un point d’arrivée F et de chercher, parmi toutes les trajectoires possibles les rejoignant, la plus courte.

On constate déjà que si I et F sont dans le même milieu homogène, le trajectoire la plus courte sera le segment de droite [IF] et donc le principe de Fermat prédit bien que la lumière se propage rectilignement dans un milieu homogène.

Et quand le point d’arrivée F est dans un autre milieu que le point de départ I, la prise en compte de l’effet du milieu comme un ralentissement apparent de la vitesse de la lumière (dans un milieu d’indice optique $n$, la lumière voyage à la vitesse $c/n$ où $c$ est sa célérité dans le vite, soit $300\,000$ km/s) permet de retrouver le phénomène de réfraction : la lumière change de direction en passant d’un milieu à l’autre. La déviation est telle que le trajet global sera le moins long possible et donc la partie du trajet dans le milieu d’indice optique supérieur sera plus petite que l’autre.

C’est très élégant, mais n’est-ce pas que cela ? une raffinerie calculatoire ? Comment en effet la lumière pourrait-elle aller explorer les différents chemins avant de choisir le moins long ? Cela paraît saugrenu… Du moins du côté particulaire de notre description de la lumière. Car pour une onde, ça n’est pas si bizarre. Une onde est en effet intrinsèquement la modélisation d’un comportement collectif. Considérer une onde, c’est donc bien considérer différents trajets pris “à la fois”.

En 1678, Hygens s’est dit qu’en décomposant ce mouvement collectif en une multitudes d’ondelettes individuelles, on pourrait déterminer l’évolution de la forme de l’onde principale par sommation de toutes ces petites ondes. On obtient en particulier des fronts d’onde capables d’expliquer les propagation circulaire et rectiligne de lumière ainsi que la réfraction.

En 1818, Fresnel ajouta un élément clé à cette vision des choses : les interférences entre ces multitudes ondelettes. Les interférences destructives peuvent créer des zones noires même là où la lumière s’est propagée. Fresnel fut alors en mesure d’expliquer la plupart des phénomènes optiques.

Le paramètre primordial devient ainsi la phase $\phi=\omega t-\vec{k}\cdot\vec{r}$ (avec $\|\vec{k}\|=k=\frac{n \omega}{c}$. À un instant donné, son extrémisation ($\nabla \phi =0$) peut nous donner un $\vec{k}$ constant dans le cas d’un milieu homogène où la loi de Snell de la réfraction ($n_1\sin(\theta_1)=n_1\sin(\theta_2)$) au niveau d’une interface.